文献计量学分析实战(2)——pyBibx_python bibpy-程序员宅基地

Python中pyBibx库是文献计量学分析较好的库,有着丰富的方法。

1 安装

pip install pyBibx2 数据

见本文绑定资源

3 实战分析

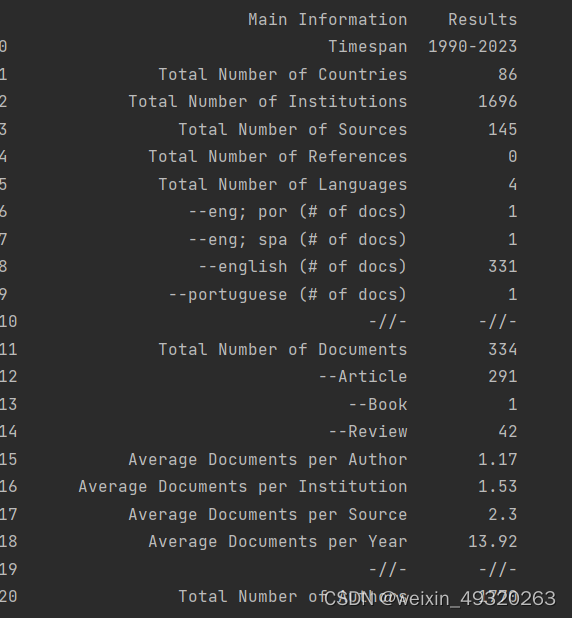

3.1 导入数据和总结汇报

import numpy as np

import pandas as pd

import textwrap

from pyBibX.base import pbx_probe

from prettytable import PrettyTable

file_name = 'pubmed.txt'

database = 'pubmed'

# load data

bibfile = pbx_probe(file_bib=file_name, db=database, del_duplicated=True)

# Generate EDA (Exploratory Data Analysis) Report

report = bibfile.eda_bib()

# Check Report

report

3.2 词云

bibfile.word_cloud_plot(entry='kwa', size_x=15, size_y=10, wordsn=500)

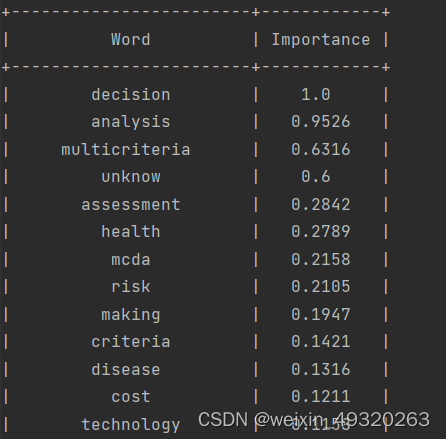

3.3 词语重要性排序

# Check Table for important word

table = PrettyTable()

data_wd = bibfile.ask_gpt_wd

table.field_names = ['Word', 'Importance']

for key, value in data_wd.items():

table.add_row([key, round(value, 4)])

print(table)

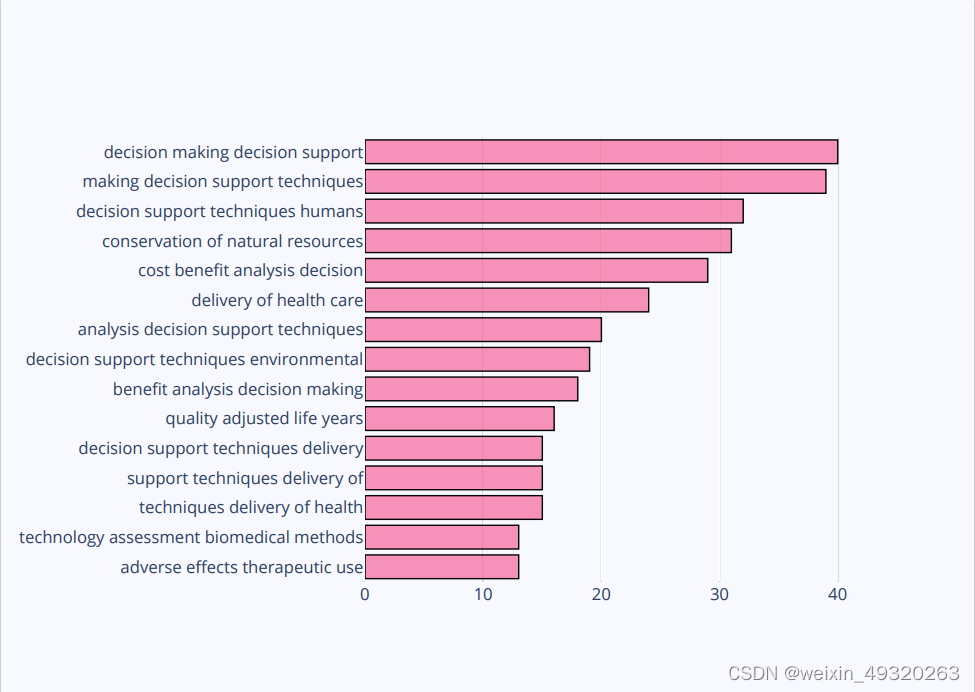

3.4 N-Grams:是文本文档中n个连续项目的集合,可能包括单词、数字、符号和标点符号。

bibfile.get_top_ngrams(view='notebook', entry='kwp', ngrams=4, stop_words=[], rmv_custom_words=[], wordsn=15)

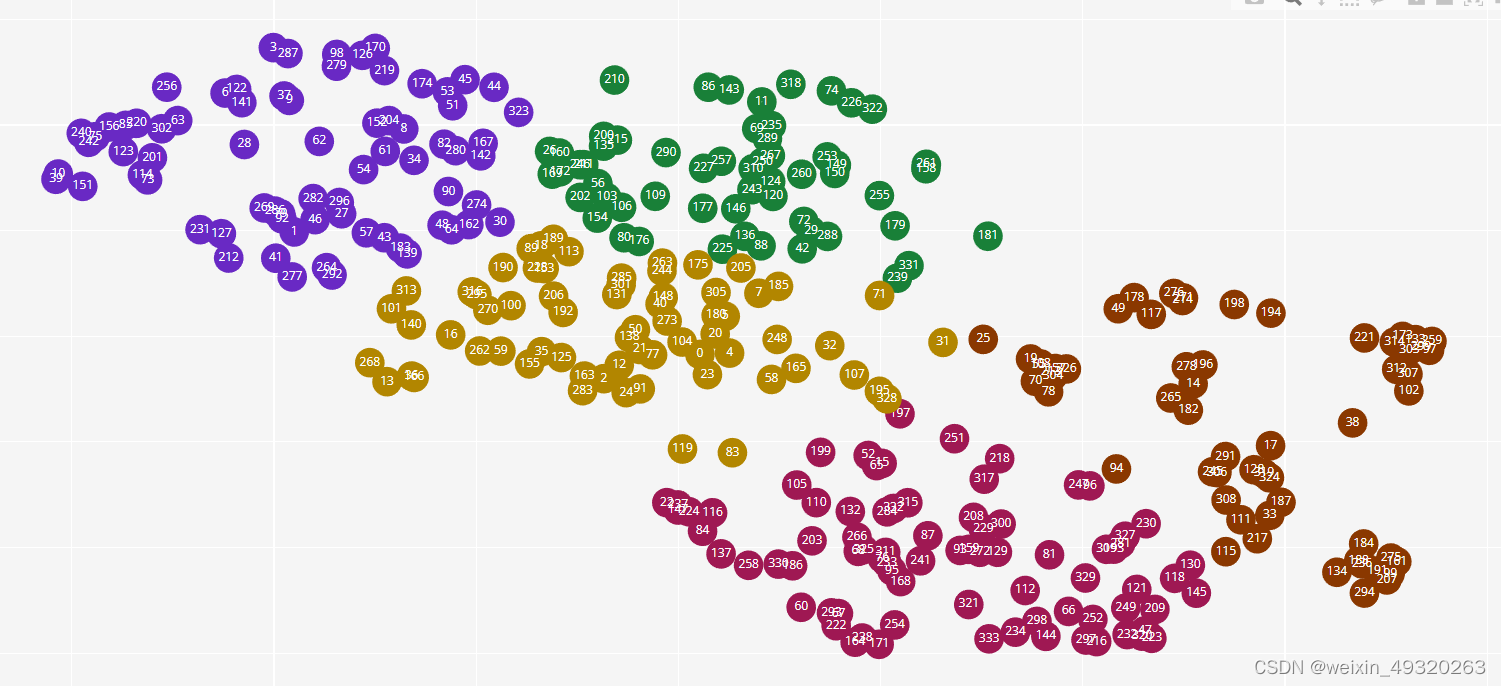

3.5 文章聚类

projection, labels = bibfile.docs_projection(view='notebook',corpus_type='abs',

stop_words=['en'],rmv_custom_words=[],

custom_label=[],custom_projection=[],

n_components=2,n_clusters=5,

tf_idf=False,embeddings=False,

method='umap')

data_pr = pd.DataFrame(np.hstack([projection, labels.reshape(-1,1)]))

# Check Articles per Cluster

cluster = 1

idx_articles = [i for i in range(0, labels.shape[0]) if labels[i] == cluster]

print(*idx_articles, sep=', ')

3.6 每年关键词变化

bibfile.plot_evolution_year(view='notebook',

stop_words=['en'],

rmv_custom_words=[],

key='kwp',

topn=10,

start=2010,

end=2021)

# View Table

data_ep = bibfile.ask_gpt_ep

3.7 作者/国家/杂志桑基图

bibfile.sankey_diagram(view='notebook', entry=['aut', 'cout', 'inst', 'lan'], topn=10)

# View Table

data_sk = bibfile.ask_gpt_sk

pd.DataFrame(data_sk)

3.8 杂志热图

bibfile.tree_map(entry='jou', topn=20, size_x=30, size_y=30)

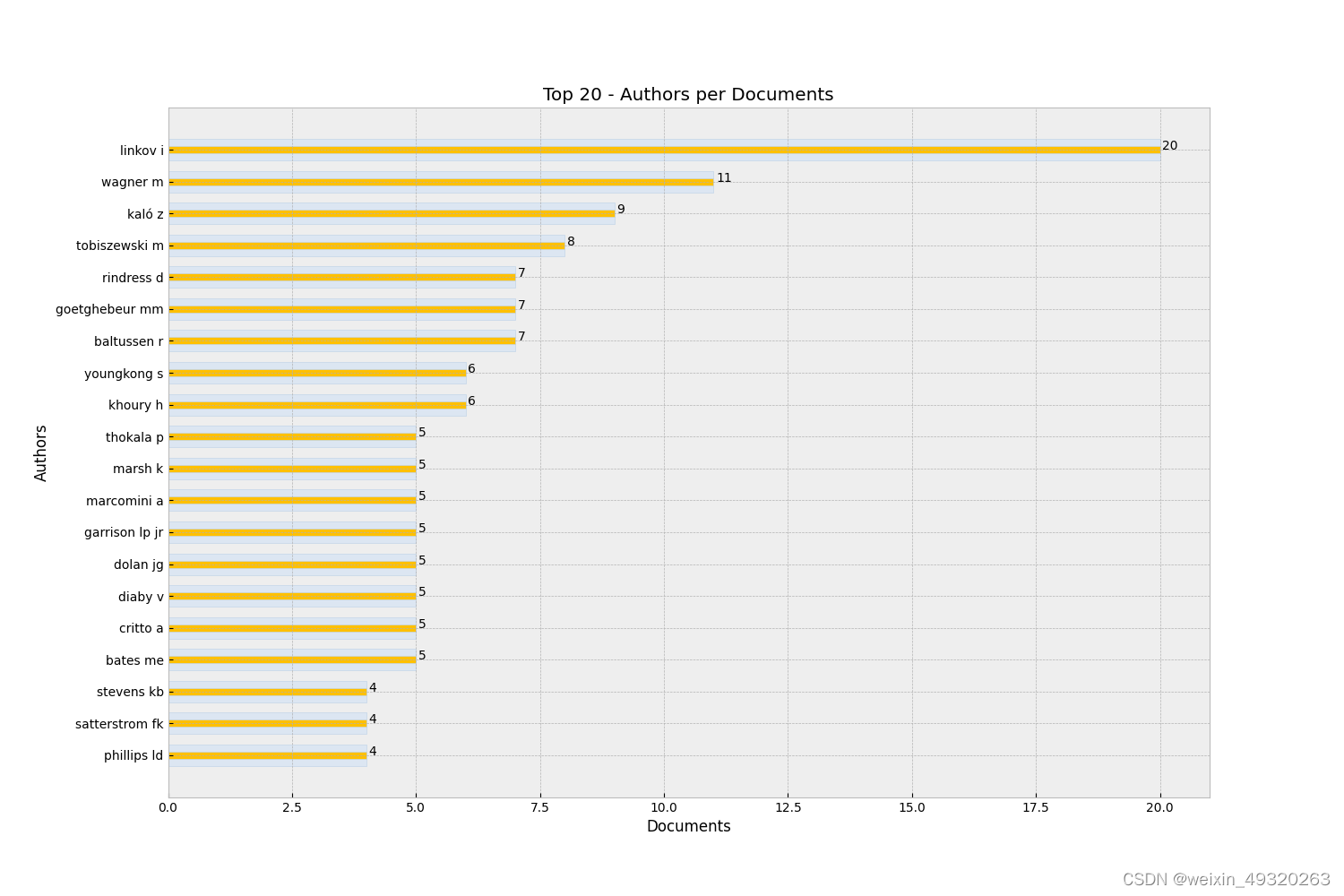

3.9 作者产出图

bibfile.authors_productivity(view='notebook', topn=20)

3.10 作者产出柱状图

bibfile.plot_bars(statistic='apd', topn=20, size_x=15, size_y=10)

# View Table

data_bp = bibfile.ask_gpt_bp

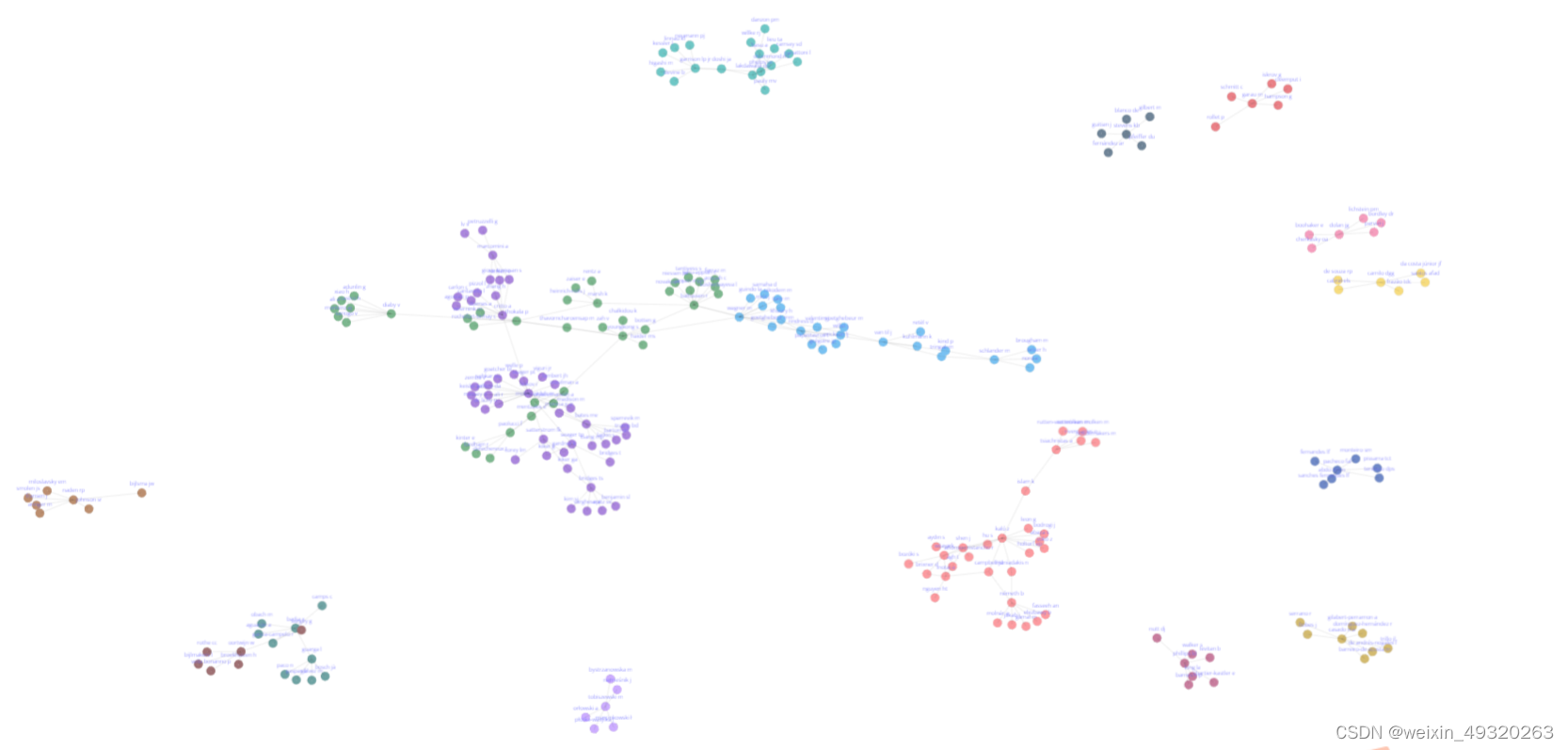

3.11 合作网络图

bibfile.network_adj(view = 'notebook', adj_type = 'aut', min_count = 5, node_labels = True, label_type = 'name', centrality = None)

# PS: If a centrality criterion is used then the values can be obtained by the following command: bibfile.table_centr

# View Table

data_adj = bibfile.ask_gpt_adj

bibfile.find_nodes(node_ids = [], node_name = ['youngkong s'], node_only = False)

3.12 合作世界地图

bibfile.network_adj_map(view = 'browser', connections = True, country_lst = [])

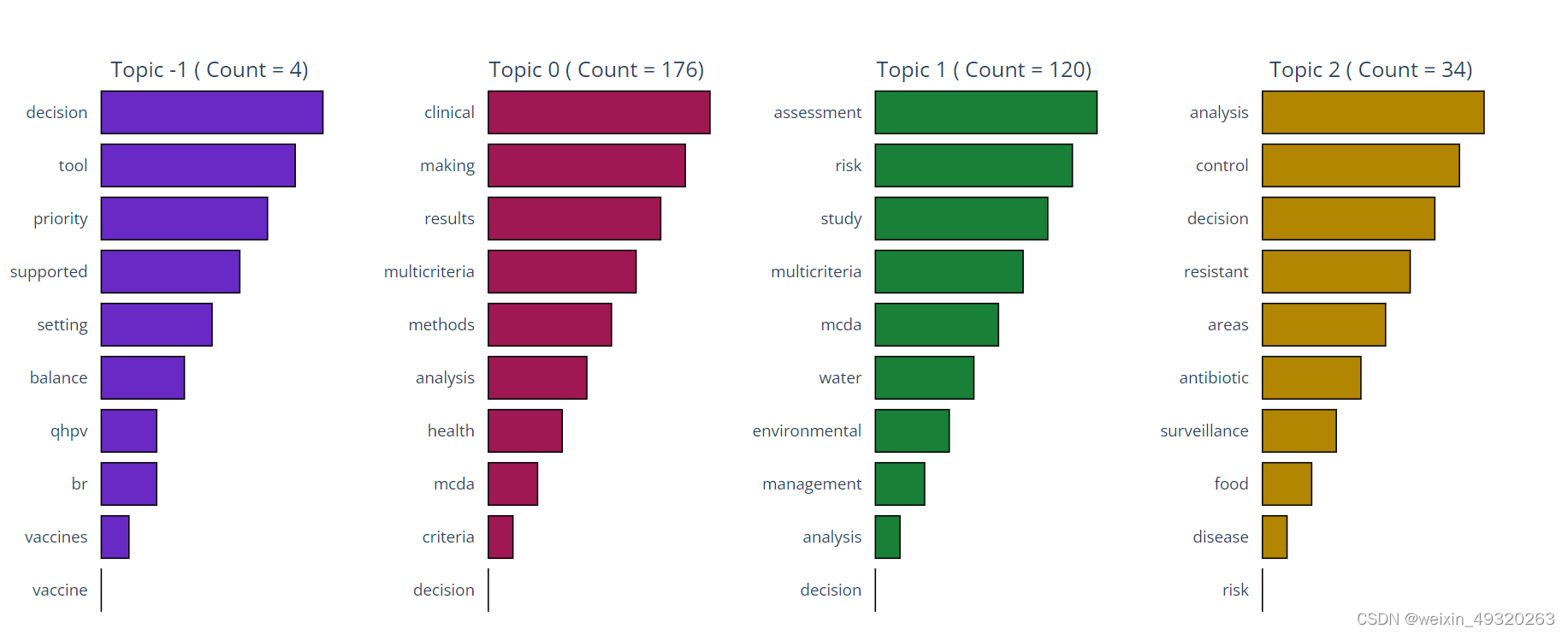

3.13 NLP:自然语言处理

# NLP

# Arguments: corpus_type = 'abs', 'title', 'kwa', or 'kwp';

# stop_words = A list of stopwords to clean the corpus. ['ar', 'bn', 'bg', 'cs', 'en', 'fi', 'fr', 'de', 'el', 'hi', 'he', 'hu', 'it', 'ja', 'ko', 'mr', 'fa', 'pl', 'pt-br', 'ro', 'ru', 'es', 'sv', 'sk', 'zh', 'th', 'uk'];

# 'ar' = Arabic; 'bn' = Bengali; 'bg' = Bulgarian; 'cs' = Czech; 'en' = English; 'fi' = Finnish; 'fr' = French; 'de' = German; 'el' = Greek; 'he' = Hebrew;…n;

# 'ja' = Japanese; 'ko' = Korean; 'mr' = Marathi; 'fa' = Persian; 'pl' = Polish; 'pt-br' = Potuguese-Brazilian; 'ro' = Romanian; 'ru' = Russian; 'es' = Spanish; 'sk' = Slovak; 'sv' = Swedish;

# 'zh' = Chinese; 'th' = Thai; 'uk' = Ukrainian

# rmv_custom_words = A list of custom stopwords to clean the corpus;

bibfile.create_embeddings(stop_words = ['en'], rmv_custom_words = [], corpus_type = 'abs')

emb = bibfile.embds

# NLP #-1 refers to all outliers and should typically be ignored.

# Arguments: stop_words = A list of stopwords to clean the corpus. ['ar', 'bn', 'bg', 'cs', 'en', 'fi', 'fr', 'de', 'el', 'hi', 'he', 'hu', 'it', 'ja', 'ko', 'mr', 'fa', 'pl', 'pt-br', 'ro', 'ru', 'es', 'sv', 'sk', 'zh', 'th', 'uk'];

# 'ar' = Arabic; 'bn' = Bengali; 'bg' = Bulgarian; 'cs' = Czech; 'en' = English; 'fi' = Finnish; 'fr' = French; 'de' = German; 'el' = Greek; 'he' = Hebrew;'hi' = Hindi; 'hu' = Hungarian; 'it' = Italian;

# 'ja' = Japanese; 'ko' = Korean; 'mr' = Marathi; 'fa' = Persian; 'pl' = Polish; 'pt-br' = Potuguese-Brazilian; 'ro' = Romanian; 'ru' = Russian; 'es' = Spanish; 'sk' = Slovak; 'sv' = Swedish;

# 'zh' = Chinese; 'th' = Thai; 'uk' = Ukrainian

# rmv_custom_words = A list of custom stopwords to clean the corpus;

# embeddings = True or False. If True then word embeddings are used to create the topics

bibfile.topics_creation(stop_words = ['en'], rmv_custom_words = [], embeddings = True)

# NLP

# Each document Topic

topics = bibfile.topics

# NLP

# Each document Probability to belong a Topic

probs = bibfile.probs

# NLP

# Arguments: view = 'notebook', 'browser' ('notebook' -> To plot in your prefered Notebook App. 'browser' -> To plot in your prefered browser window)

bibfile.graph_topics_distribution(view = 'notebook')

# NLP

# Arguments: view = 'notebook', 'browser' ('notebook' -> To plot in your prefered Notebook App. 'browser' -> To plot in your prefered browser window)

bibfile.graph_topics(view = 'notebook')

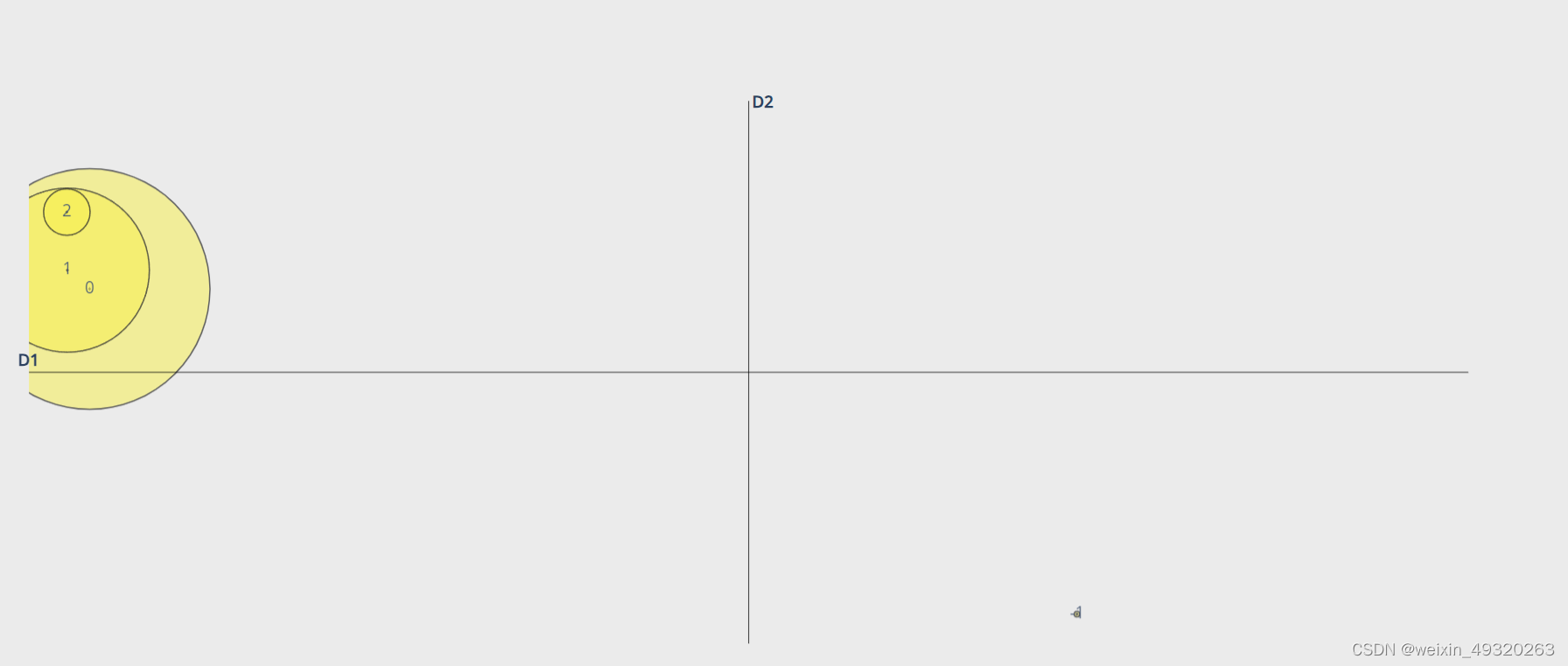

# NLP

# Arguments: view = 'notebook', 'browser' ('notebook' -> To plot in your prefered Notebook App. 'browser' -> To plot in your prefered browser window)

bibfile.graph_topics_projection(view = 'notebook')

# NLP

# Arguments: view = 'notebook', 'browser' ('notebook' -> To plot in your prefered Notebook App. 'browser' -> To plot in your prefered browser window)

bibfile.graph_topics_heatmap(view = 'notebook')

# NLP

similar_topics, similarity = bibfile.topic_model.find_topics('electre', top_n = 10)

for i in range(0, len(similar_topics)):

print('Topic: ', similar_topics[i], 'Correlation: ', round(similarity[i], 3))

# NLP

bibfile.topic_model.save('my_topic_model')

abs_summary = bibfile.summarize_abst_peg(article_ids = [305, 34, 176], model_name = './pegasus-xsum')

# NLP - Check Abstractive Summarization

print(textwrap.fill(abs_summary, 150))

abs_summary_chat = bibfile.summarize_abst_chatgpt(article_ids = [305, 34, 176], join_articles = True, api_key = 'your_api_key_here', query = 'from the following scientific abstracts, summarize the main information in a single paragraph using around 250 words', model = 'gpt-4')

# NLP - Check Abstractive Summarization

print(textwrap.fill(abs_summary_chat, 250))

# NLP - Extractive Summarization

# Arguments: article_ids = A list of documents to perform an extractive summarization with the available abstracts. If the list is empty then all documents will be used

ext_summary = bibfile.summarize_ext_bert(article_ids = [305, 34, 176])

# NLP - Check Extractive Summarization

print(textwrap.fill(ext_summary, 150))上述可总结摘要

3.14 筛选文章

bibfile.filter_bib(documents = [], doc_type = [], year_str = -1, year_end = -1, sources = [], core = -1, country = [], language = [], abstract = False)感兴趣的可以参考原始指南:

智能推荐

51单片机的中断系统_51单片机中断篇-程序员宅基地

文章浏览阅读3.3k次,点赞7次,收藏39次。CPU 执行现行程序的过程中,出现某些急需处理的异常情况或特殊请求,CPU暂时中止现行程序,而转去对异常情况或特殊请求进行处理,处理完毕后再返回现行程序断点处,继续执行原程序。void 函数名(void) interrupt n using m {中断函数内容 //尽量精简 }编译器会把该函数转化为中断函数,表示中断源编号为n,中断源对应一个中断入口地址,而中断入口地址的内容为跳转指令,转入本函数。using m用于指定本函数内部使用的工作寄存器组,m取值为0~3。该修饰符可省略,由编译器自动分配。_51单片机中断篇

oracle项目经验求职,网络工程师简历中的项目经验怎么写-程序员宅基地

文章浏览阅读396次。项目经验(案例一)项目时间:2009-10 - 2009-12项目名称:中驰别克信息化管理整改完善项目描述:项目介绍一,建立中驰别克硬件档案(PC,服务器,网络设备,办公设备等)二,建立中驰别克软件档案(每台PC安装的软件,财务,HR,OA,专用系统等)三,能过建立的档案对中驰别克信息化办公环境优化(合理使用ADSL宽带资源,对域进行调整,对文件服务器进行优化,对共享打印机进行调整)四,优化完成后..._网络工程师项目经历

LVS四层负载均衡集群-程序员宅基地

文章浏览阅读1k次,点赞31次,收藏30次。LVS:Linux Virtual Server,负载调度器,内核集成, 阿里的四层SLB(Server Load Balance)是基于LVS+keepalived实现。NATTUNDR优点端口转换WAN性能最好缺点性能瓶颈服务器支持隧道模式不支持跨网段真实服务器要求anyTunneling支持网络private(私网)LAN/WAN(私网/公网)LAN(私网)真实服务器数量High (100)High (100)真实服务器网关lvs内网地址。

「技术综述」一文道尽传统图像降噪方法_噪声很大的图片可以降噪吗-程序员宅基地

文章浏览阅读899次。https://www.toutiao.com/a6713171323893318151/作者 | 黄小邪/言有三编辑 | 黄小邪/言有三图像预处理算法的好坏直接关系到后续图像处理的效果,如图像分割、目标识别、边缘提取等,为了获取高质量的数字图像,很多时候都需要对图像进行降噪处理,尽可能的保持原始信息完整性(即主要特征)的同时,又能够去除信号中无用的信息。并且,降噪还引出了一..._噪声很大的图片可以降噪吗

Effective Java 【对于所有对象都通用的方法】第13条 谨慎地覆盖clone_为继承设计类有两种选择,但无论选择其中的-程序员宅基地

文章浏览阅读152次。目录谨慎地覆盖cloneCloneable接口并没有包含任何方法,那么它到底有什么作用呢?Object类中的clone()方法如何重写好一个clone()方法1.对于数组类型我可以采用clone()方法的递归2.如果对象是非数组,建议提供拷贝构造器(copy constructor)或者拷贝工厂(copy factory)3.如果为线程安全的类重写clone()方法4.如果为需要被继承的类重写clone()方法总结谨慎地覆盖cloneCloneable接口地目的是作为对象的一个mixin接口(详见第20_为继承设计类有两种选择,但无论选择其中的

毕业设计 基于协同过滤的电影推荐系统-程序员宅基地

文章浏览阅读958次,点赞21次,收藏24次。今天学长向大家分享一个毕业设计项目基于协同过滤的电影推荐系统项目运行效果:项目获取:https://gitee.com/assistant-a/project-sharing21世纪是信息化时代,随着信息技术和网络技术的发展,信息化已经渗透到人们日常生活的各个方面,人们可以随时随地浏览到海量信息,但是这些大量信息千差万别,需要费事费力的筛选、甄别自己喜欢或者感兴趣的数据。对网络电影服务来说,需要用到优秀的协同过滤推荐功能去辅助整个系统。系统基于Python技术,使用UML建模,采用Django框架组合进行设

随便推点

你想要的10G SFP+光模块大全都在这里-程序员宅基地

文章浏览阅读614次。10G SFP+光模块被广泛应用于10G以太网中,在下一代移动网络、固定接入网、城域网、以及数据中心等领域非常常见。下面易天光通信(ETU-LINK)就为大家一一盘点下10G SFP+光模块都有哪些吧。一、10G SFP+双纤光模块10G SFP+双纤光模块是一种常规的光模块,有两个LC光纤接口,传输距离最远可达100公里,常用的10G SFP+双纤光模块有10G SFP+ SR、10G SFP+ LR,其中10G SFP+ SR的传输距离为300米,10G SFP+ LR的传输距离为10公里。_10g sfp+

计算机毕业设计Node.js+Vue基于Web美食网站设计(程序+源码+LW+部署)_基于vue美食网站源码-程序员宅基地

文章浏览阅读239次。该项目含有源码、文档、程序、数据库、配套开发软件、软件安装教程。欢迎交流项目运行环境配置:项目技术:Express框架 + Node.js+ Vue 等等组成,B/S模式 +Vscode管理+前后端分离等等。环境需要1.运行环境:最好是Nodejs最新版,我们在这个版本上开发的。其他版本理论上也可以。2.开发环境:Vscode或HbuilderX都可以。推荐HbuilderX;3.mysql环境:建议是用5.7版本均可4.硬件环境:windows 7/8/10 1G内存以上;_基于vue美食网站源码

oldwain随便写@hexun-程序员宅基地

文章浏览阅读62次。oldwain随便写@hexun链接:http://oldwain.blog.hexun.com/ ...

渗透测试-SQL注入-SQLMap工具_sqlmap拖库-程序员宅基地

文章浏览阅读843次,点赞16次,收藏22次。用这个工具扫描其它网站时,要注意法律问题,同时也比较慢,所以我们以之前写的登录页面为例子扫描。_sqlmap拖库

origin三图合一_神教程:Origin也能玩转图片拼接组合排版-程序员宅基地

文章浏览阅读1.5w次,点赞5次,收藏38次。Origin也能玩转图片的拼接组合排版谭编(华南师范大学学报编辑部,广州 510631)通常,我们利用Origin软件能非常快捷地绘制出一张单独的绘图。但是,我们在论文的撰写过程中,经常需要将多种科学实验图片(电镜图、示意图、曲线图等)组合在一张图片中。大多数人都是采用PPT、Adobe Illustrator、CorelDraw等软件对多种不同类型的图进行拼接的。那么,利用Origin软件能否实..._origin怎么把三个图做到一张图上

51单片机智能电风扇控制系统proteus仿真设计( 仿真+程序+原理图+报告+讲解视频)_电风扇模拟控制系统设计-程序员宅基地

文章浏览阅读4.2k次,点赞4次,收藏51次。51单片机智能电风扇控制系统仿真设计( proteus仿真+程序+原理图+报告+讲解视频)仿真图proteus7.8及以上 程序编译器:keil 4/keil 5 编程语言:C语言 设计编号:S0042。_电风扇模拟控制系统设计